En semaine 1, nous avons examiné l’ingestion de données depuis S3, allons maintenant un peu plus loin. Cette semaine, nous avons plusieurs tâches à accomplir. Rien de révolutionnaire, mais ce défi pourrait vous faire transpirer un peu une fois que vous aurez commencé à construire la solution.

Frosty Friday Inc., votre employeur, possède un bucket S3 rempli de fichiers de données au format .csv.

La plupart de ces fichiers ne sont pas très compliqués et ont tous le même format et le même contenu. Tous ces fichiers doivent être ingérés dans une seule table.

Cependant, il se peut que d’autres données importantes aient été uploadées sur ce bucket. Ces fichiers suivent une convention de nommage différente et doivent être identifiés et monitorés. Vous devez donc stocker leurs métadonnées à des fins de référence dans une autre table.

Vous pourrez reconnaître les fichiers importants grâce au fichier keyword.csv présent dans le bucket S3. Il contient les différents mots-clés qui marquent un fichier comme important.

Objectif :

Créez une table qui répertorie tous les fichiers du stage qui contiennent l’un des mots-clés du fichier keywords.csv.

L’URI du bucket S3 est le suivant : s3://frostyfridaychallenges/challenge_3/

Résultat :

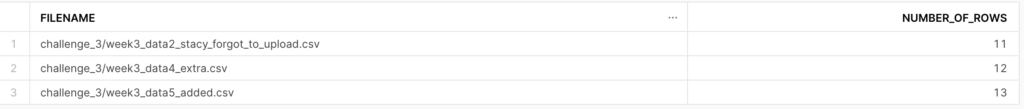

Votre résultat devrait ressembler à ceci :

Et n’oubliez pas, si vous souhaitez participer aux défis:

1. Inscrivez-vous en tant que membre de Frosty Friday. –> Vous pouvez le faire en cliquant sur la barre latérale, puis en cliquant sur ‘REGISTER‘ (notez que s’inscrire à notre liste de diffusion ne vous donne pas de compte Frosty Friday).

2. Publiez votre code sur GitHub et rendez-le accessible au public (consultez notre guide si vous ne savez pas comment faire, disponible ici)

3. Postez l’URL dans les commentaires du défi.

Si vous avez des questions techniques que vous souhaitez poser à la communauté, vous pouvez les poser ici, sur notre thread dédié.

Laisser un commentaire

Vous devez vous connecter pour publier un commentaire.